Cloudflare me rompió el robots.txt (por “Bloquear bots de IA”): qué pasó, cómo detectarlo y cómo arreglarlo

Víctor Aprendiz de SEO

Autor

Resumen rápido

Activé “Bloquear bots de IA” en nuevos dominios de Cloudflare y, sin darme cuenta, el robots.txt empezó a devolver contenido no estándar. Resultado: errores en Search Console, pérdida de presupuesto de rastreo y directivas ignoradas. Aquí te cuento cómo lo detecté, cómo lo arreglé y qué puedes hacer para que no te pase.

Qué ocurrió exactamente

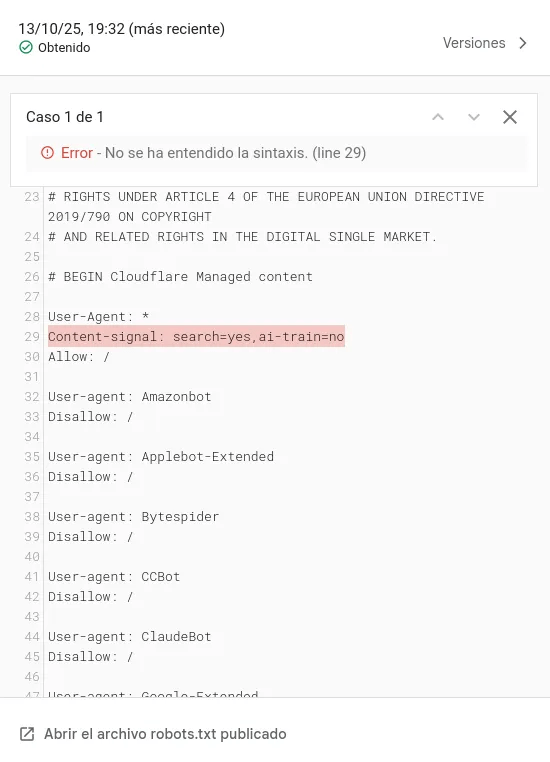

Al activar “Bloquear bots de IA” en Cloudflare, el robots.txt empezó a incluir texto ajeno a mis directivas (un bloque “legal/político” que invalida la sintaxis). Googlebot y otros rastreadores lo interpretan como robots inválido, lo que puede provocar:

- Directivas

Disallow/Allowignoradas - Errores en Search Console

- Presupuesto de rastreo malgastado y picos de páginas excluidas

Señales de que te está pasando

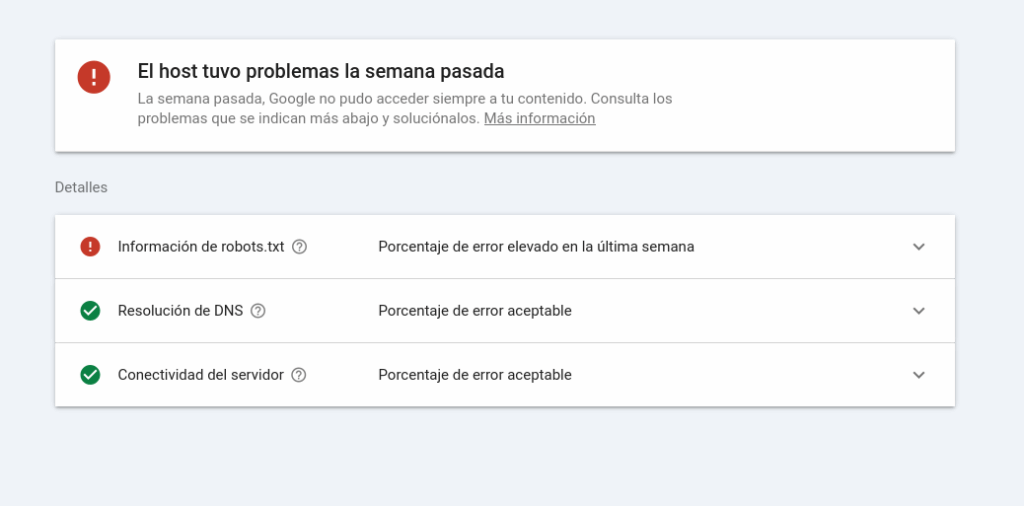

Para saber si te está pasando puedes ir a GSC y mirar alguna de estas dos cosas:

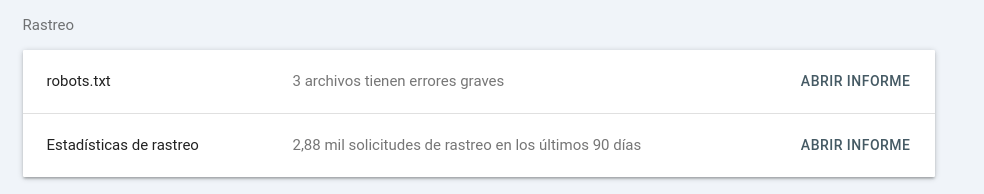

- En Páginas/Rastreo, hay errores relacionados con

robots.txt(como en la imagen). - Si abres

https://tudominio.com/robots.txt, aparece texto extraño encima/debajo de tus reglas. Mal rollo.

La solución (paso a paso)

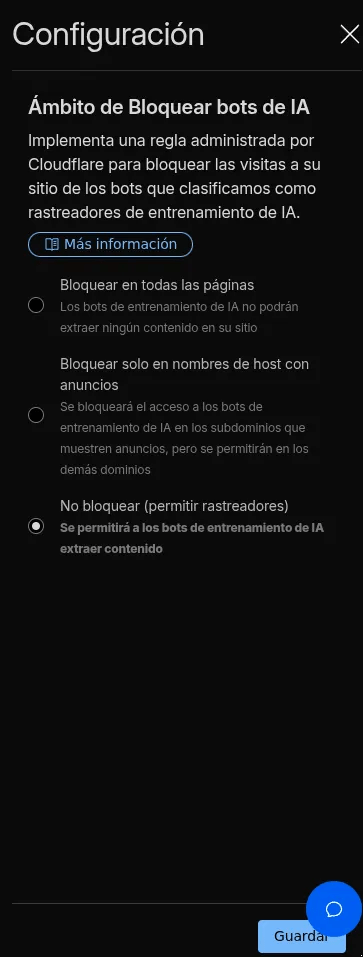

- Desactiva “Bloquear bots de IA”

Cloudflare → Seguridad → Configuración → Bloquear bots de IA → Editar (lápiz) → No bloquear → Guardar. - Purga la caché

Cloudflare → Almacenamiento en caché → Configuración → Purgar todo. - Evita que

robots.txtse cachee (recomendación extra)- Cloudflare → Reglas → Reglas de caché → Crear regla

- Condición: URL completa

contiene/robots.txt - Acciones: Omitir caché (Bypass cache)

Esto asegura que siempre sirvas la versión limpia desde el origen.

- Condición: URL completa

- Cloudflare → Reglas → Reglas de caché → Crear regla

- Comprueba de nuevo

- Vuelve a abrir

https://tudominio.com/robots.txten incógnito. - En Search Console → Prueba robots.txt (o valida errores al próximo rastreo).

- Vuelve a abrir

Alternativa: ¿quieres seguir bloqueando ciertos bots?

En vez de la regla global, crea Reglas personalizadas en Cloudflare (Firewall → Reglas) para bloquear User-Agents específicos de scrapers/IA que identifiques, sin tocar robots.txt. O retoca tu propio robots.txt desde tu panel de administración o hosting.

Prevención a futuro

- Monitoriza el

robots.txtcada cierto tiempo, si ves algo raro, vete a Google Search Console. - Revisa bien todo lo que hace CloudFlare con tu web, que parece ser que, a veces, la lía.

¿Has tenido esta mala experiencia? ¡Deja un comentario!